大模型(LLMs)基础面

一、介绍大模型

大模型:一般指1亿以上参数的模型,但是这个标准一直在升级,目前万亿参数以上的模型也有了。

大语言模型(Large Language Model,LLM)是针对语言的大模型。

大模型后面跟的6B、13B等,这些一般指参数的个数,B是Billion/十亿的意思。

二、主流框架体系

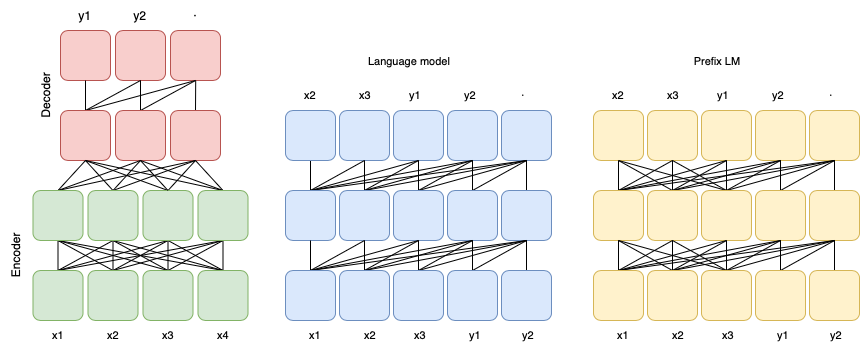

大模型主要架构分为三种::prefix Decoder 系、causal Decoder 系、Encoder-Decoder。

##### 第一种:prefix Decoder系

* 介绍:输入双向注意力,输出单向注意力

* 代表模型:ChatGLM、ChatGLM2、U-PaLM

##### 第二种 :causal Decoder系

* 介绍:从左到右的单向注意力

* 代表模型:LLaMA-7B、LLaMa衍生物

##### 第三种:Encoder-Decoder

* 介绍:输入双向注意力,输出单向注意力

* 代表模型:T5、Flan-T5、BART

二、prefix Decoder 和 causal Decoder 和 Encoder-Decoder区别是什么?

prefix Decoder 和 causal Decoder 和 Encoder-Decoder 区别是在于 attention mask不同:

- Encoder-Decoder:

- 在输入上采用双向注意力,对问题的编码理解更充分

- 适用任务:在偏理解的NLP任务上效果好

- 缺点:在长文本生成任务上效果差,训练效率低

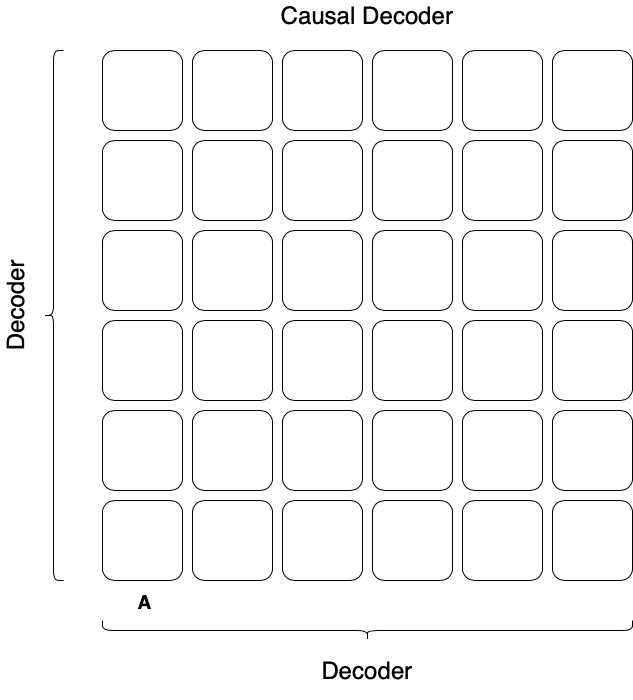

- causal Decoder:

- 自回归语义模型,预训练和下游应用是完全一致的,严格遵守 只有后面的token才能看到前面的token的规则

- 适用于任务:文本生成任务效果好

- 优点:训练效率高,zero-shot能力更强,具有涌现能力

- prefix Decoder:

- 特点:prefix部分的token互相能看到 ,causal Decoder 和 Encoder-Decoder 折中

- 缺点:训练效率低